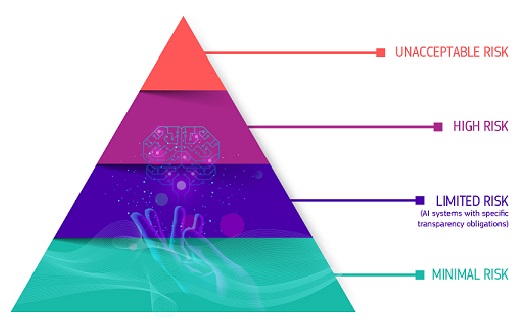

El pasado 4 de febrero la Comisión Europea publicaba las Directrices sobre prácticas prohibidas de inteligencia artificial (IA), según se definen en la Ley de IA. Estas directrices proporcionan explicaciones jurídicas y ejemplos prácticos para ayudar a las partes interesadas a comprender y cumplir los requisitos de la Ley Europea de Inteligencia Artificial (Ley de IA) que entró en vigor en agosto de 2024 y está diseñada para garantizar que la IA desarrollada y utilizada en la Unión Europea sea fiable y proteja los derechos fundamentales, clasificando los sistemas de IA en 4 categorías de riesgo: mínimo, limitado – específico de transparencia, alto e inaceptable.

La reciente publicación sobre las directrices ofrece información valiosa sobre la interpretación de las prohibiciones por parte de la Comisión, no son vinculantes y las interpretaciones autorizadas se reservan al Tribunal de Justicia de la Unión Europea (TJUE). La publicación sobre las directrices aborda específicamente prácticas como la manipulación dañina, la puntuación social y la identificación biométrica remota en tiempo real, entre otras.

En este artículo nos centraremos en las directrices proporcionadas en materia de educación. Pero, para ubicar estas directrices en el campo educativo, vamos a poner en contexto las prohibiciones enumeradas en el artículo 5 de la Ley de IA:

- Artículo 5(1)(a) Manipulación dañina y engaño. Sistemas de IA que emplean técnicas subliminales que van más allá de la conciencia de una persona o técnicas deliberadamente manipuladoras o engañosas, con el objetivo o el efecto de distorsionar el comportamiento, causando o es razonablemente probable que causen un daño significativo.

- Artículo 5(1)(b) Explotación dañina de vulnerabilidades. Sistemas de IA que explotan vulnerabilidades debidas a la edad, la discapacidad o una situación social o económica específica, con el objetivo o el efecto de distorsionar el comportamiento, causando o es razonablemente probable que causen un daño significativo

- Artículo 5(1)(c) Puntuación social. Sistemas de IA que evalúan o clasifican a personas físicas o grupos de personas en función de su comportamiento social o de sus características personales o de personalidad, y la puntuación social da lugar a un trato perjudicial o desfavorable cuando los datos proceden de contextos sociales no relacionados o dicho trato es injustificado o desproporcionado con respecto al comportamiento social

- Artículo 5(1)(d) Evaluación y predicción del riesgo de delito penal individual. Sistemas de IA que evalúan o predicen el riesgo de que las personas cometan un delito penal basándose únicamente en la elaboración de perfiles o en rasgos y características de personalidad; excepto para respaldar una evaluación humana basada en hechos objetivos y verificables directamente vinculados a una actividad delictiva

- Artículo 5(1)(e) Extracción no dirigida para desarrollar bases de datos de reconocimiento facial. Sistemas de IA que crean o amplían bases de datos de reconocimiento facial mediante la extracción no dirigida de imágenes faciales de Internet o de imágenes de circuito cerrado de televisión (CCTV)

- Artículo 5(1)(f) Reconocimiento de emociones. Sistemas de IA que infieren emociones en el lugar de trabajo o en instituciones educativas; excepto por razones médicas o de seguridad

- Artículo 5(1)(g) Categorización biométrica. Sistemas de IA que categorizan a las personas en función de sus datos biométricos para deducir o inferir su raza, opiniones políticas, afiliación sindical, creencias religiosas o filosóficas, vida sexual u orientación sexual; excepto para el etiquetado o filtrado de conjuntos de datos biométricos adquiridos legalmente, incluso en el ámbito de la aplicación de la ley.

- Artículo 5(1)(h) Identificación biométrica remota en tiempo real (RBI). Sistemas de IA para la identificación biométrica remota en tiempo real en espacios de acceso público con fines de aplicación de la ley; excepto si es necesario para la búsqueda dirigida de víctimas específicas, la prevención de amenazas específicas, incluidos los ataques terroristas, o la búsqueda de sospechosos de delitos específicos (otros requisitos de procedimiento, incluidos los de autorización, se describen en el artículo 5(2-7) de la Ley de IA).

Tras este contexto volvemos al Artículo 5(1)(f) Reconocimiento de emociones pues es en este apartado donde las directrices proporcionadas en la publicación hacen hincapié para el entorno educativo.

La tecnología de reconocimiento que recopila, analiza, categoriza, reacciona y aprende de las emociones de las personas también se conoce como “tecnología de afectos”. El reconocimiento de emociones se puede utilizar en múltiples áreas y dominios para una amplia gama de aplicaciones, como para analizar el comportamiento del cliente y la publicidad dirigida y el neuromarketing. En educación, por ejemplo, para controlar la atención o el compromiso de los alumnos (alumnos y estudiantes de diferentes edades). En la citada Ley de IA se explica que el reconocimiento de emociones puede conducir a «resultados discriminatorios y puede ser intrusivo para los derechos y libertades de las personas interesadas», en particular los derechos a la privacidad, la dignidad humana y la libertad de pensamiento. Esto tiene un papel importante en las relaciones asimétricas, especialmente en las instituciones de educación y formación, donde tanto los trabajadores como los estudiantes se encuentran en posiciones particularmente vulnerables.

Por ello, en las directrices facilitadas, se recomienda la prohibición de la comercialización, la puesta en servicio para este fin específico o el uso de sistemas de IA para inferir las emociones de una persona física en los ámbitos del lugar de trabajo y de las instituciones educativas, excepto cuando el uso del sistema de IA esté destinado a implementarse o comercializarse por razones médicas o de seguridad.

La referencia a las instituciones educativas es amplia y debe entenderse que incluye tanto a las instituciones públicas como a las privadas. No hay ninguna limitación en cuanto a los tipos o edades de los alumnos o estudiantes o de un entorno específico (en línea, en persona, en una modalidad combinada, etc.). Las instituciones de educación y formación de todos los niveles caen dentro del ámbito de aplicación de la prohibición del artículo 5(1)(f) de la Ley AI. Vamos a ver algunos casos que sirven para ver los límites de los usos permitidos y aquellos que están prohibidos:

- En la publicación se explica claramente que una institución educativa que utilice un software de seguimiento ocular, basado en IA, al examinar a los estudiantes en línea a fin de rastrear el punto de fijación y el movimiento de los ojos (el punto de mirada, por ejemplo, para detectar si se utiliza material no autorizado) no está prohibida, porque el sistema no identifica ni infiere emociones. Por el contrario, si el sistema también se utiliza para detectar emociones, como la excitación emocional y la ansiedad, esto entraría dentro del alcance de la prohibición.

- El uso de un sistema de IA de reconocimiento de emociones por parte de una institución educativa para inferir el interés y la atención de los estudiantes está prohibido. Pero, si solo se implementa con fines de aprendizaje en el contexto de un juego de roles (por ejemplo, para capacitar a actores o maestros), los sistemas de reconocimiento de emociones están permitidos si los resultados no pueden afectar la evaluación o certificación de la persona que se está capacitando.

- Por otro lado, en el ámbito educativo no está prohibido el uso de un sistema de IA que permita capturar a los estudiantes hablando entre sí a través de sus teléfonos u otros canales durante las conferencias en línea por parte de una institución educativa, ya que no infiere emociones. Sin embargo, si el sistema también se utiliza para detectar emociones, como la excitación emocional, la ansiedad y el interés, sí estaría prohibido.

- Sí queda prohibido el uso de un sistema de IA de reconocimiento de emociones por parte de una institución educativa durante las pruebas de admisión del alumnado, así como el reconocimiento de emociones tanto en los docentes (en su lugar de trabajo) como en el alumnado.

La prohibición del artículo 5(1)(f) de la Ley de IA contempla una excepción explícita para los sistemas de reconocimiento de emociones utilizados en el ámbito laboral y en instituciones educativas por razones médicas o de seguridad, como los sistemas para uso terapéutico.

Esta nueva publicación de la Comisión Europea supone un importante hito en la protección de las personas usuarias de la herramientas de IA y, en especial, en el ámbito educativo en el que la protección de la infancia es fundamental. No obstante, sería positivo contar con desarrollos más concretos de los estados miembros, bien conjuntos o individualmente, para seguir delimitando los parámetros que aseguren un uso respetuoso, ético y responsable de la inteligencia artificial en educación.